Ollama部署本地大模型

1 摘要¶

利用Ollama实现如Deepseek-R1等大模型的本地部署,并在局域网内实现大模型的接入使用、保存历史记录等功能。

必要性

第一,使用网页版的大语言模型可能在隐私泄露上具有一定风险,本地部署能够让数据全部保存在本地,这是本地部署一个模型的原因。

第二,网页交互的大语言模型对于语境简单的问答具有非常好的表现,但是对于某些需要专业知识库的东西表现并不算好。为了解决这类问题,可以使用RAG(Retrieval-Augmented Generation)技术,自己构建的知识库为大模型提供需要的语境,而无需使用非常长的context来给大模型提示。虽然API也可以使用RAG,但是对于一些需要保密的知识库,本地部署大模型则必不可少了。

2 条件¶

1) 足够的GPU(显存)。

2) 足够的存储空间。

一般对于同一个模型(如Deepseek-R1),模型参数越大,模型效果越好,但同时对于电脑的配置要求也就越高。

3 下载安装Ollama¶

Ollama是一个开源Ollama 是一个开源的本地大语言模型运行框架,专为在本地机器上便捷部署和运行大型语言模型(LLM)而设计。它支持多种流行的大模型,如 Llama、DeepSeek-R1、Qwen 等。

为了能够部署运行Deepseek-R1,我们首先需要下载软件Ollama,直接前往官网下载即可。

下载完成后,运行安装即可。Ollama会自动安装到C盘,没有选择的余地。不过不用担心,我们后面可以通过设置环境变量来更改模型的保存位置。

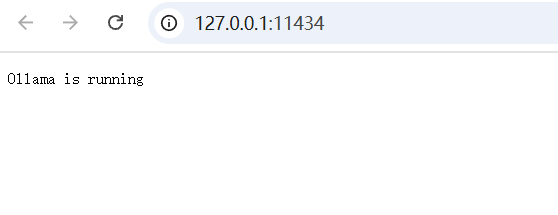

安装完成后,进入127.0.0.1:11434,如果网站显示Ollama is running就表示安装好了。

4 配置Ollama环境变量¶

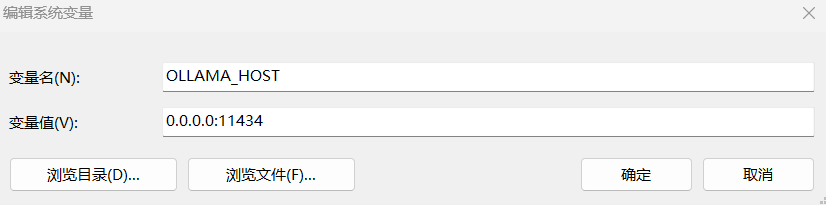

4.1 打开11434端口¶

安装好Ollama之后,本机可以在浏览器直接通过端口11434进行访问,看到Ollama is running的字样,但是对于局域网内的其他设备是无法通过[ip]:[11434]进行访问的(此处的ip指安装了Ollama主机的局域网ip)。为了实现其他设备的访问,我们需要在环境变量中添加如下内容:

如下所示:

保存配置,重启Ollama,即可在局域网内的所有设备通过[ip]:[11434]进行访问。

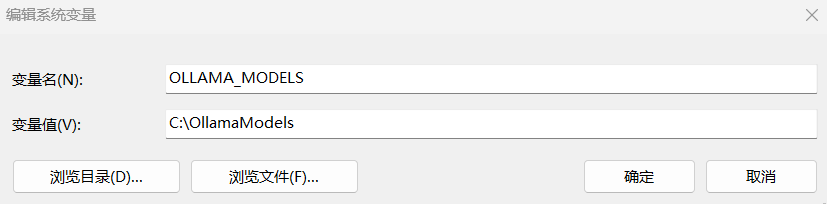

4.2 修改模型默认保存位置¶

Ollama模型默认下载位置在C盘,如果要修改保存位置,请在环境变量中添加如下内容:

此处我是把C盘设置为保存路径:

配置完成后,需要重启Ollama,配置即可生效。

5 下载Deepseek-R1模型¶

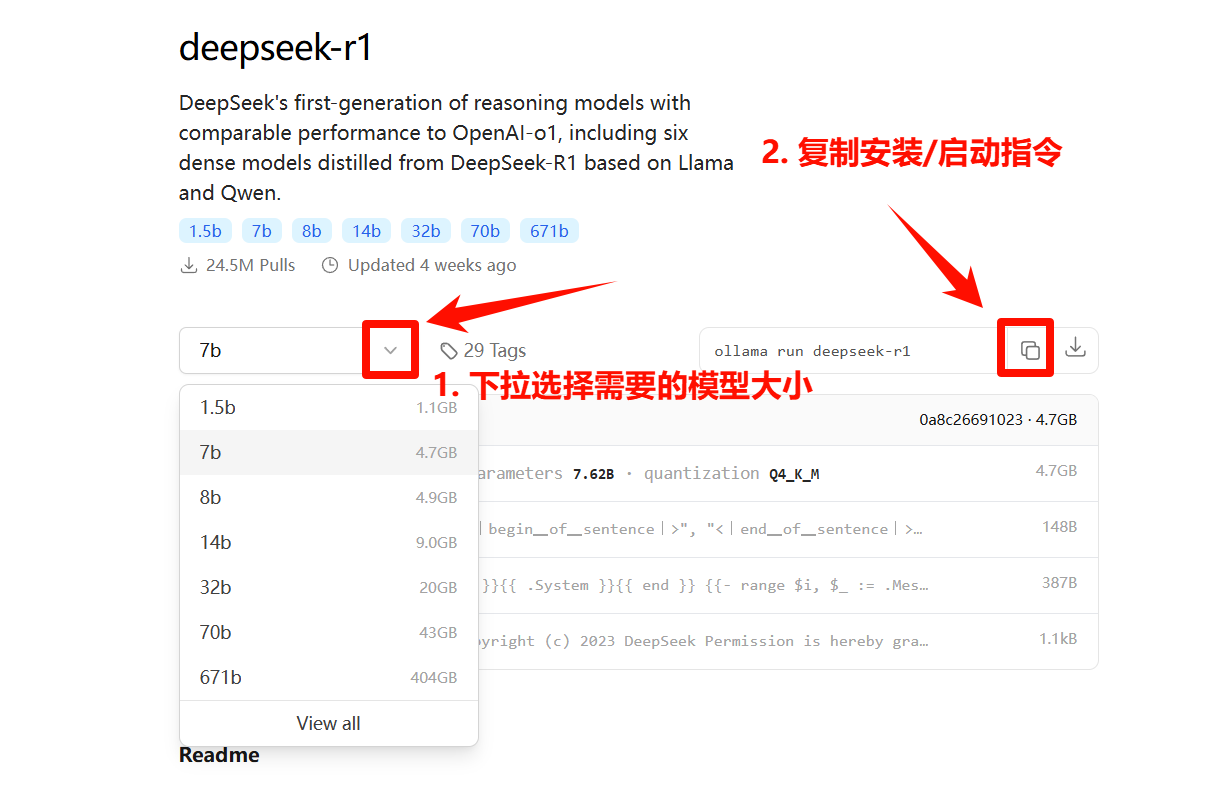

进入官网的Deepseek-R1模型下载区,进行如下操作。

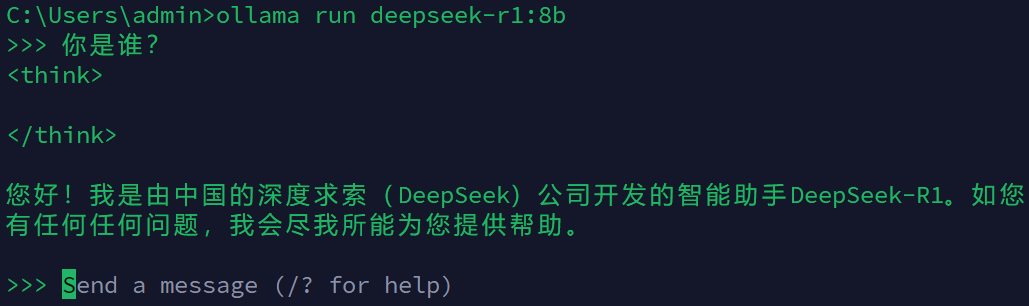

打开本机电脑的CMD终端,将复制的指令粘贴运行,等待下载完成之后会自动进入对话模式。

可以使用ollama --help指令可以查看Ollama常用指令:

Large language model runner

Usage:

ollama [flags]

ollama [command]

Available Commands:

serve Start ollama

create Create a model from a Modelfile

show Show information for a model

run Run a model

stop Stop a running model

pull Pull a model from a registry

push Push a model to a registry

list List models

ps List running models

cp Copy a model

rm Remove a model

help Help about any command

Flags:

-h, --help help for ollama

-v, --version Show version information

Use "ollama [command] --help" for more information about a command.

6 对话工具推荐¶

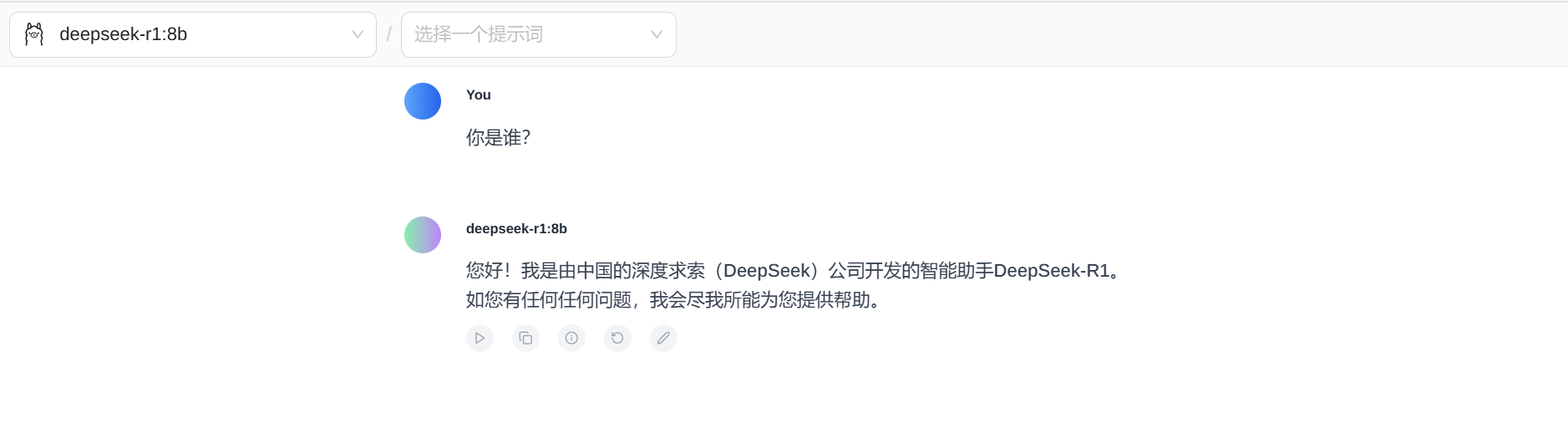

Ollama进行的是终端的交互,为了保存历史记录,推荐在Chrome浏览器中使用插件Page Assist进行对话,该插件可以直接调用本地的模型,数据也保存在本地。

此外,CherryStudio也是不错的本地对话应用,但没有Page Assist轻量化。